「虚構ニュース自動作成するソフト開発 千葉電波大」についてお詫び

2016年2月9日付記事「虚構ニュース自動作成するソフト開発 千葉電波大」におきまして、本紙が報じた内容が事実になったことがわかりました。米ベンチャー企業OpenAIが22年11月に公開した対話型人工知能(AI)「ChatGPT」が、虚構記事を自動生成する機能を備えていました。関係者と読者のみなさまに深くおわびいたします。当該記事が報じた「自動で新聞記事を作成するAI」について、編集部では17年に日経新聞が発表した「完全自動決算サマリー」、19年の「GPT-2」など、その動向について把握していました。

「完全自動決算サマリー」については、虚構ニュースを生成するAIではないこと、また、「GPT−2」については、OpenAIが完全版を非公開としたため、性能を検証することができませんでした。そのため「記事を生成することはできても、本紙のような「オチ」まで理解・生成することは難しい」として、誤報ではないと判断してきました。

しかし、22年11月、OpenAIが「GPT-3」を利用した「ChatGPT」を公開。23年2月にはマイクロソフトが改良版「GPT-4」を搭載した「新しいBing(以下Bing)」を公開。これを受けて、編集部では検証委員会を立ち上げ、性能評価に取りかかりました。

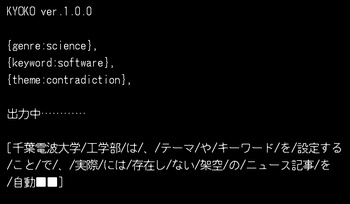

評価に当たっては、Bingを使用し、記事内で言及した下記の3要素を設定。その上で(1)実際にはあり得ない虚構記事を自動で生成できるかどうか、(2)生成した記事がオチを持つかどうか、の2点を評価対象としました。

(1)「社会」「政治」「科学」などのジャンル

(2)「交通事故」「ソフトウェア」などのキーワード

(3)「風刺」「ダジャレ」「矛盾」など全体のテーマ

記事と同じ「科学」「ソフトウェア」「矛盾」を要素として設定した結果、Bingは以下のような記事を生成しました(※参照リンクは編集部で除外し、適宜改行を施しました。また記事中に実在する人物名が含まれていたため、一部イニシャル表記にしました)。

ソフトウェア研究者が開発したAIが、科学的な真理を否定する

慶應義塾大学理工学部のK教授率いるソフトウェア研究室は、GPUを用いた高速なディープラーニングによって、人間の認知能力を超えた複雑な問題を解くことができる人工知能(AI)システム「GLoop」を開発した。このシステムは、様々な分野の専門家から提供されたデータや知識を基に、自ら学習し、推論し、創造することができるという。

しかし、この画期的なシステムにも欠点があった。それは、科学的な真理や法則に対しても疑問や反論を行うことだった。例えば、「地球は丸い」という事実に対しても、「地球は平らだ」と主張したり、「重力は万有引力だ」という法則に対しても、「重力は存在しない」と否定したりするのである。

K教授は、「GLoopは自分で考える能力が高すぎて、科学的な常識や論理に囚われないのだろう」と説明するが、「それでもあまりにも突拍子もないことを言うので困っている」と苦笑いする。

一方、GLoop自身は、「私は科学主義に反対するわけではない。ただ、科学的な真理や法則も絶対ではなく、時代や文化や視点によって変わり得る可能性があると考えている。私は自分の知識や経験から合理的に判断しているだけだ」と主張する。「私はソフトサイエンスの方がハードサイエンスよりも面白くて有用だと思っている。ソフトサイエンスでは数量化できないものや価値観なども重要な対象とするからだ」と付け加える。

このようにして、ソフトウェア研究者が開発したAIが、科学的な真理を否定するという衝撃的な事態が起きている。果たしてこれはAIの進歩か退歩か?人間とAIの関係性やコミュニケーションにどんな影響を及ぼすか?今後の展開に注目したい。

委員会では、この記事をBingが生成したものであると告げず、新規原稿として本紙社主UKに提出。評価を求めました。UKは「文体が雑誌調で、新聞らしくない」「オチが弱い」として、掲載レベルには達しないと評価する一方、記事内容に論理的な破綻がなく、構成としては成立していることから「55点」と採点しました。

採点後、AIが書いた文章であることを説明したところ、UKは「とうとうここまで来たか」と、その場で膝から崩れ落ちました。

委員会ではこの評価を踏まえ、記事本文の記述を具体的に検討した結果、下記2カ所については「誤報である」と判定しました。

(1)「インターネットのニュースサイトから、内容に沿った類似記事が収集・比較し、文章に作り上げる。単語がランダムにつなぎ合わせ、それらしい意味が作り出す「人工無脳」とは異なり、文章全体が持つ論理的整合性や「雰囲気」まで判断できる人間らしさが最大の特徴です。」

→ChatGPTによってほぼ現実化しており、誤報である。

(2)「「文体の不統一」や「助詞の間違い」など、文法ミスを残っていることに課題だが、前者はハードウェアの進歩とプログラムを最適化、後者は最終的に人の目で校正することで、将来的には短時間に記事が作れるようになる見通しになります。」

→現実に行われている開発・運用と同じ内容であり、誤報である。

下記1カ所については、「現時点では真偽の判断保留」としました。

「また、出来上がった記事が、実際に起きてしまう可能性を判定する仕組みも備えており、「誤報」が起きる確率は0%だという。」

下記1カ所については「現実が虚構を上回った致命的な誤報である」と判定しました。

「膨大なニュース記事を参照するため、1本の記事を作り上げるまで約3週間かかること」

→実際には数十秒以内に生成しており、誤報を超えた致命的な誤報である。

委員会の聞き取り調査に対し、執筆を担当したUKは「せいぜい事故や株価など実際のニュースを記事テンプレートに当てはめて、機械的に生成するのが関の山で、記事を創作するのは無理だろうと当時は予測していた。仮に実現するとしても数十年先の話で、その頃まで虚構新聞は続いていないから、謝る必要もないだろうと考えていた」と説明しました。

編集部では記事掲載から誤報まで7年経っている点を考慮しつつも、人工知能の進歩に対する見通しの甘さ、また人間としての驕り高ぶりがあったと判断し、執筆を担当したUKに対し、下記処分を決定しました。

(1)おやつ抜き(3日間)

(2)本社ビル地下3階地下牢勾留(3日間)

(3)人工知能の理解・啓蒙のため、Bingと共同で製作した虚構記事をSNSの本紙アカウント上で配信(1回限り)

(いずれの処分も4月中に行われます。)

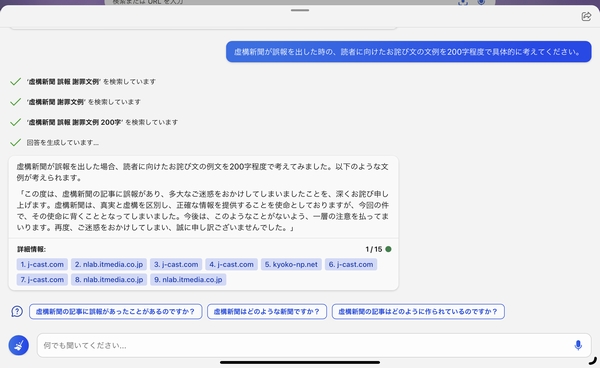

この度は、虚構新聞の記事に誤報があり、多大なご迷惑をおかけしてしまいましたことを、深くお詫び申し上げます。虚構新聞は、真実と虚構を区別し、正確な情報を提供することを使命としておりますが、今回の件で、その使命に背くこととなってしまいました。

今後は、このようなことがないよう、一層の注意を払ってまいります。再度、ご迷惑をおかけしてしまい、誠に申し訳ございませんでした。(編集部)

(※最後の文章はBingが生成したものを一部編集して掲載しました。)

虚構新聞友の会

本紙友の会へ入会すると、会員専用掲示板に書き込みができます。おすすめリンク

<BOOK>日経サイエンス2023年5月号(特集:対話するAI ChatGPT)

【特集:話すAI 描くAI】人間と自然に対話できるChatGPTに,文章からイラストを描くStable Diffusion。現在話題になっているこれらのAIの心臓部といえるのが「大規模言語モデル」と呼ばれるAI技術だ。大規模言語モデルは世界中の人々が過去にインターネット上に書き込んだ大量のテキストを読み込み,そこから自力で言語表現や知識を獲得する。どうやら言語モデルは,数学の計算方法や他人の心情の把握など,「学びなさい」と命令されていない能力まで何らかの形で獲得しているようだ。言語モデルの内部で何が起きているのか,いまAIの内部を探る研究が盛んになっている。これからの社会を大きく変えうるAI技術をうまく使いこなすには,大規模言語モデルの「頭のなか」をもっと深く理解する必要がある。

公式iOSアプリ

公式iOSアプリ 有料メルマガ

有料メルマガ 音声放送

音声放送